Robots.txt – учимся правильно писать!

Поисковые роботы при заходе на сайт обращаются к файлу robots.txt, который дает им информацию о том, что нельзя индексировать. Поэтому каждый вебмастер должен знать, как правильно написать файл robots.txt, иначе неправильное написание этого файла к хорошему не приведет.

Файл robots.txt – это файл с расширением «txt», в котором содержится информация по индексации для поисковых роботов. Его создают с помощью обычного блокнота, затем заливают в корень сайта.

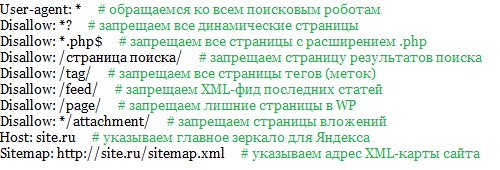

Вот примерное содержание файла robots.txt:

User-agent: *

Disallow: /adminka/

Disallow: /image/

А теперь разберём содержание этого файла:

Строка «User-agent: *» – Звёздочка в строке User-agent означает, что данная инструкция относится ко всем поисковым роботам. Если вы хотите чтобы инструкция относилась к конкретному поисковому роботу, тогда вам нужно прописать его имя.

Вторая и третья строка запрещают индексацию директорий adminka и image. Каждая запрещенная к индексации директория прописана с новой строки. Совмещение этих директорий в одной строке является грубой ошибкой.

P.S. Купить ноутбук acer одесса , а также аксессуары для него у нас можно по лучшим ценам в регионе.

Для поискового робота Яндекса нужно писать директиву Host, она указывает роботу на основное зеркало этого сайта. Как правило в этой директиве должен быть прописан адрес сайта. Пример написания директивы Host:

User-agent: Yandex

Disallow: /adminka/

Host: www.site.ru

Примеры написания файла robots txt:

1. Сайт запрещен к индексации для всех поисковых роботов.

User-agent: *

Disallow: /

2. Сайт не запрещен к индексации для всех поисковых роботов.

User-agent: *

Disallow:

3. Сайт запрещен к индексации только для робота SeoBot.

User-agent: SeoBot

Disallow: /

4. Сайт не запрещен к индексации для робота SeoBot, но зато запрещен к индексации для всех остальных роботов.

User-agent: SeoBot

Disallow:

User-agent: *

Disallow: /

5. Запрет на индексацию для некоторых директорий всеми поисковыми роботами.

User-agent: *

Disallow: /directoria-1/

Disallow: /directoria-1/

Disallow: /hidedirectoria/

6. Запрет на индексацию этих файлов для всех поисковых роботов.

User-agent: *

Disallow: /hide.php

Disallow: /secret.html

Правила написания содержимого файла robots.txt:

1. Содержимое файла robots.txt должно быть написано в нижним реестре.

2. В каждой инструкции Disallow указывать только одну директорию или один файл.

3. Нельзя менять местами Disallow и User-agent.

4. Строка User-agent не должна быть пуста.

5. В директиве Host (для Яндекса) адрес нужно писать без http:// и без слеша /.

6. Не пишите комментарии к инструкциям в одной строке с инструкциями.

7. Инструкцию Disallow ни в коем случае нельзя пропускать. Если вы не собираетесь ничего запрещать к индексации, то оставьте эту инструкцию пустой.

8. Если директория запрещается к индексации, не забывайте в конце директории прописывать слеш.

10. И последнее, перед тем, как залить файл robot.txst в корень сайта,